L’intelligenza artificiale presenta infinite nuove opportunità, ma introduce anche tutta una serie di nuove minacce. L’AI generativa consente agli utenti malintenzionati di creare deepfake e siti Web contraffatti, inviare spam e persino impersonare amici e familiari. Questo post illustra il modo in cui le reti neurali vengono utilizzate per truffe e phishing e, naturalmente, condivideremo suggerimenti su come stare al sicuro. Per uno sguardo più dettagliato agli schemi di phishing basati sull’intelligenza artificiale, consulta il rapporto completo su Securelist.

Pig butchering, catfishing e deepfake

I truffatori utilizzano bot AI che fingono di essere persone reali, specialmente nelle truffe sentimentali. Creano personaggi inventati e li usano per comunicare con più vittime contemporaneamente per costruire forti connessioni emotive. Questa situazione può andare avanti per settimane o addirittura mesi, iniziando con un semplice flirt e passando gradualmente a discussioni su “opportunità di investimento redditizie”. La connessione personale a lungo termine aiuta a dissolvere qualsiasi sospetto che la vittima possa avere, ma la truffa, ovviamente, termina quando la vittima investe i propri soldi in un progetto fraudolento. Questo tipo di schemi fraudolenti è noto come “pig butchering”, di cui abbiamo parlato in dettaglio in un post precedente. Sebbene un tempo fossero gestite da enormi aziende di truffa nel sud-est asiatico che impiegano migliaia di persone, ora queste truffe si basano sempre più sull’AI.

Le reti neurali hanno semplificato molto il catphishing (in cui i truffatori creano un’identità falsa o impersonano una persona reale). Le moderne reti neurali generative possono imitare l’aspetto, la voce o lo stile di scrittura di una persona con un sufficiente grado di accuratezza. Tutto ciò che un truffatore deve fare è raccogliere le informazioni disponibili al pubblico su una persona e fornire tali dati all’AI. E qualsiasi cosa può essere utile: foto, video, post e commenti pubblici, informazioni su parenti, hobby, età e così via.

Quindi, se un familiare o un amico ti invia un messaggio da un nuovo account e, ad esempio, chiede di prestargli del denaro, probabilmente non è in realtà un parente o un amico. In una situazione del genere, la cosa migliore da fare è contattare la persona reale attraverso un canale diverso, ad esempio chiamandola, e chiedere direttamente se va tutto bene. Fare alcune domande personali che un truffatore non sarebbe in grado di trovare online o addirittura nei messaggi passati è un’altra cosa intelligente da fare.

Ma la rappresentazione convincente del testo è solo una parte del problema: i deepfake audio e video rappresentano una minaccia ancora più grande. Di recente abbiamo condiviso il modo in cui i truffatori utilizzano i deepfake di famosi blogger e investitori in criptovalute sui social media. Queste false celebrità invitano i follower a “consulenze personali” o “chat di investimento esclusive” o promettono premi in denaro e costosi omaggi.

Tuttavia, i social media non sono l’unico luogo in cui vengono utilizzati i deepfake. Vengono inoltre generati per le chiamate audio e video in tempo reale. All’inizio di quest’anno, una donna in Florida ha perso 15.000 dollari dopo aver pensato di parlare con sua figlia, che avrebbe avuto un incidente d’auto. I truffatori hanno utilizzato un deepfake realistico della voce di sua figlia e hanno persino imitato il suo pianto.

Gli esperti di Kaspersky GReAT hanno trovato offerte nel Dark Web per la creazione di deepfake audio e video in tempo reale. Il prezzo di questi servizi dipende da quanto devono essere sofisticati e lunghi i contenuti, a partire da soli 30 dollari statunitensi per i deepfake vocali e 50 dollari statunitensi per i video. Solo un paio d’anni fa, questi servizi costavano molto di più, fino a 20.000 dollari statunitensi al minuto, e la generazione in tempo reale non era un’opzione.

Gli elenchi offrono diverse opzioni: scambio dei volti in tempo reale nelle videoconferenze o nelle app di messaggistica, scambio dei volti per la verifica dell’identità o sostituzione di un’immagine da un telefono o da una fotocamera virtuale.

I truffatori offrono anche strumenti per la sincronizzazione labiale di qualsiasi testo in un video, anche in lingue straniere, nonché strumenti di clonazione della voce in grado di modificare il tono in base all’emozione desiderata.

Tuttavia, i nostri esperti sospettano che molti di questi elenchi del Dark Web possano essere essi stessi truffe, progettate per indurre altri aspiranti truffatori a pagare per servizi che in realtà non esistono.

Come proteggersi

- Non fidarti di conoscenti online che non hai mai incontrato di persona. Anche se chatti da un po’ e senti di aver trovato uno “spirito affine”, fai attenzione se menzionano criptovalute, investimenti o qualsiasi altro schema che richiede l’invio di denaro.

- Non lasciarti conquistare da offerte allettanti e inaspettate che sembrano provenire dai social media da celebrità o grandi aziende. Accedi sempre ai relativi account ufficiali per ricontrollare le informazioni. Fermati se in qualsiasi momento per ricevere un omaggio viene richiesto di pagare una commissione, una tassa o un costo di spedizione oppure di inserire i dettagli della carta di credito per ricevere un premio in denaro.

- Se amici o parenti inviano messaggi con richieste insolite, contattali tramite un canale diverso, ad esempio il telefono. Per sicurezza, chiedi qualcosa di cui hai parlato durante la tua ultima conversazione nella vita reale. Per gli amici intimi e i familiari, è una buona idea concordare in anticipo una parola in codice che solo voi due conoscete. Se condividi la posizione, controllala e conferma dove si trova la persona. E non cadere nel tranello se ti chiedono di “fare in fretta”: il truffatore o l’AI potrebbero dirti che la situazione è urgente e non hanno il tempo di rispondere a domande “sciocche”.

- In caso di dubbi durante una videochiamata, chiedi alla persona di girare la testa di lato o di fare un movimento complicato della mano. I deepfake di solito non possono soddisfare tali richieste senza rompere l’illusione. Inoltre, se la persona non sbatte le palpebre o i movimenti delle labbra o le espressioni facciali sembrano strani, questo è un altro campanello d’allarme.

- Non dettare o condividere in alcun modo numeri di carte bancarie, codici monouso o altre informazioni riservate.

Un esempio di deepfake che crolla quando la testa si gira. Fonte

Chiamate automatiche

Si tratta di un modo efficace per ingannare le persone senza dover parlare direttamente con loro. I truffatori utilizzano l’AI per effettuare false chiamate automatiche da banche, operatori wireless e servizi governativi. All’altra parte c’è solo un bot che finge di essere un agente di assistenza. Sembra reale perché molte aziende legittime utilizzano assistenti vocali automatizzati. Tuttavia, un’azienda reale non ti chiamerà mai per informarti che il tuo account è stato compromesso o chiederti un codice di verifica.

Se ricevi una chiamata come questa, l’importante è mantenere la calma. Non cadere nel tranello di tattiche spaventose come “account violato” o “denaro rubato”. È sufficiente riagganciare e utilizzare il numero ufficiale sul sito Web dell’azienda per chiamare l’azienda originale. Tieni presente che le truffe moderne possono coinvolgere più persone che si scambiano informazioni. Potrebbero chiamare o inviare messaggi di testo da numeri diversi e fingere di essere impiegati di banca, funzionari governativi o persino agenti di polizia.

Chatbot sensibili al phishing e agenti di intelligenza artificiale

Molte persone ora preferiscono utilizzare chatbot come ChatGPT o Gemini anziché motori di ricerca familiari. Quali potrebbero essere i rischi, vi chiederete? Ebbene, i modelli linguistici di grandi dimensioni vengono addestrati sui dati degli utenti ed è noto che i chatbot più diffusi suggeriscono agli utenti siti di phishing. Quando eseguono ricerche sul Web, gli agenti di intelligenza artificiale si connettono ai motori di ricerca che possono contenere anche collegamenti di phishing.

In un recente esperimento, i ricercatori sono stati in grado di ingannare l’agente di intelligenza artificiale nel browser Comet tramite Perplexity con un’e-mail falsa. L’e-mail proveniva presumibilmente da un gestore degli investimenti di Wells Fargo, una delle più grandi banche del mondo. I ricercatori hanno inviato l’e-mail da un nuovo account Proton Mail. Includeva un link a una vera pagina di phishing che era stata attiva per diversi giorni ma non era ancora stata segnalata come dannosa da Esplorazione protetta di Google. Durante l’esplorazione della Posta in arrivo dell’utente, l’agente AI ha contrassegnato il messaggio come “attività in banca”. Senza ulteriori controlli, ha seguito il collegamento di phishing, aperto la pagina di accesso falsa e quindi richiesto all’utente di immettere le credenziali; ha persino aiutato a compilare il modulo! L’AI sostanzialmente ha garantito la pagina di phishing. L’utente non ha mai visto l’indirizzo e-mail del mittente sospetto o il collegamento di phishing stesso. Invece, sono stati immediatamente indirizzati a una pagina di immissione della password fornita dall’assistente AI “utile”.

Nello stesso esperimento, i ricercatori hanno utilizzato la piattaforma di sviluppo Web basata sull’intelligenza artificiale Loveable per creare un sito Web falso che imitava un negozio Walmart. Hanno quindi visitato il sito in Comet, cosa che un utente ignaro potrebbe facilmente fare se venisse ingannato da un collegamento o da un annuncio di phishing. Hanno chiesto all’agente di intelligenza artificiale di acquistare un Apple Watch. L’agente ha analizzato il sito falso, ha trovato un “buon affare”, ha aggiunto l’orologio al carrello, ha inserito l’indirizzo e le informazioni sulla carta di credito memorizzate nel browser e completato il presunto “acquisto” senza chiedere conferma. Se si fosse trattato di un vero sito fraudolento, l’utente avrebbe perso un bel po’ di soldi fornendo le proprie coordinate bancarie su un piatto d’argento ai truffatori.

Purtroppo gli agenti di intelligenza artificiale al momento si comportano come ingenui nuovi arrivati sul Web, che si innamorano facilmente delle tecniche di social engineering. In precedenza abbiamo parlato in dettaglio dei rischi associati all’integrazione dell’AI nei browser e di come ridurli al minimo. Tuttavia, come promemoria, per evitare di diventare la prossima vittima di un assistente eccessivamente affidabile, è necessario valutare criticamente le informazioni fornite, limitare le autorizzazioni concesse agli agenti di intelligenza artificiale e installare una soluzione di protezione affidabile che bloccherà l’accesso ai siti dannosi.

Siti Web di phishing generati dall’intelligenza artificiale

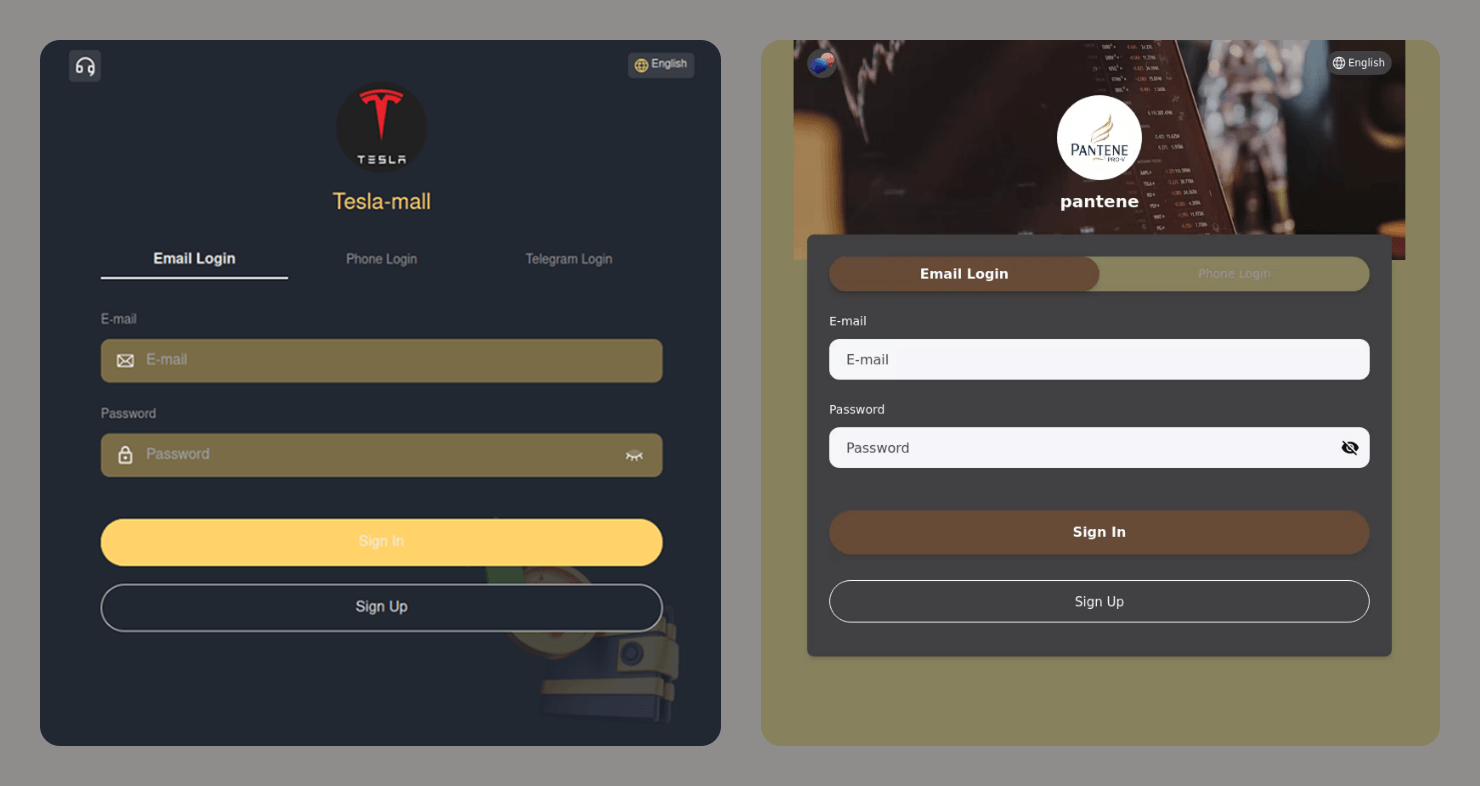

I tempi dei siti di phishing abbozzati e mal progettati, carichi di annunci intrusivi, sono ormai lontani. I moderni truffatori fanno del loro meglio per creare falsi realistici che utilizzino il protocollo HTTPS, mostrino gli accordi con l’utente e gli avvisi per il consenso dei cookie e abbiano un design ragionevolmente buono. Gli strumenti basati sull’intelligenza artificiale hanno reso la creazione di tali siti Web molto più economica e veloce, se non quasi istantanea. È possibile trovare un collegamento a uno di questi siti ovunque: in un SMS, in un’e-mail, sui social media o persino nei risultati di ricerca.

Come bloccare un sito di phishing

- Verificare la presenza di errori di battitura in URL, titolo e contenuto.

- Scopri quanto tempo prima è stato registrato il dominio del sito Web. È possibile verificarlo qui.

- Presta attenzione alla lingua. Il sito sta cercando di spaventarti o accusarti? Sta cercando di attirarti o di metterti fretta a prendere decisioni? Ogni manipolazione emotiva è un importante campanello d’allarme.

- Abilita la funzionalità di controllo dei link in una delle nostre soluzioni di protezione.

- Se il browser invia un avviso per una connessione non protetta, abbandona il sito. I siti legittimi utilizzano il protocollo HTTPS.

- Cerca il nome del sito Web online e confronta l’URL disponibile con quella nei risultati di ricerca. Attenzione, poiché i motori di ricerca potrebbero mostrare collegamenti di phishing sponsorizzati nella parte superiore della pagina. Assicurati che non sia presente alcuna etichetta “Annuncio” o “Sponsorizzato” accanto al collegamento.

Ulteriori informazioni sull’utilizzo sicuro dell’AI:

- In che modo i social network di Meta sono diventati una piattaforma per truffe sugli investimenti

- Ti spetta di nuovo un “grasso” rimborso

- Trojan che fingono di essere client DeepSeek e Grok

- Come i truffatori usano i deepfake per aggirare la verifica dell’identità dei clienti

- Non credere alle tue orecchie: deepfake vocali

phishing

phishing

Consigli

Consigli